時代が求める「説明可能なAI」-ブラックボックスを照らすXAIとは?

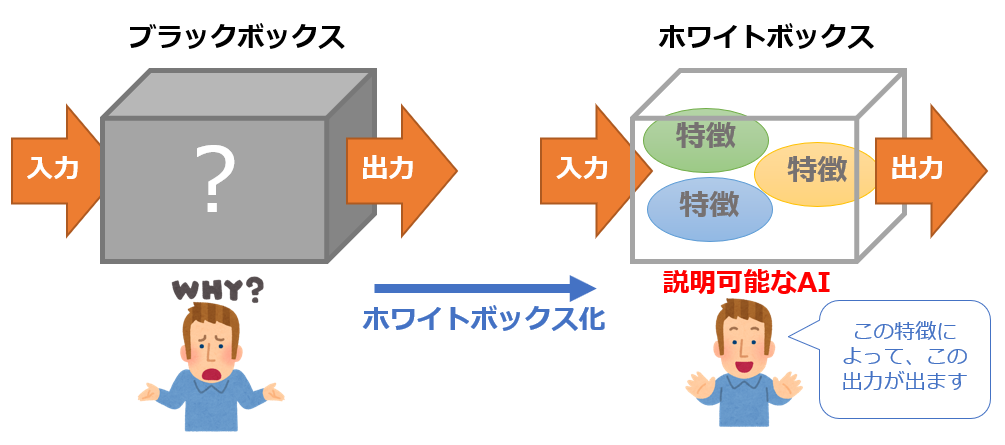

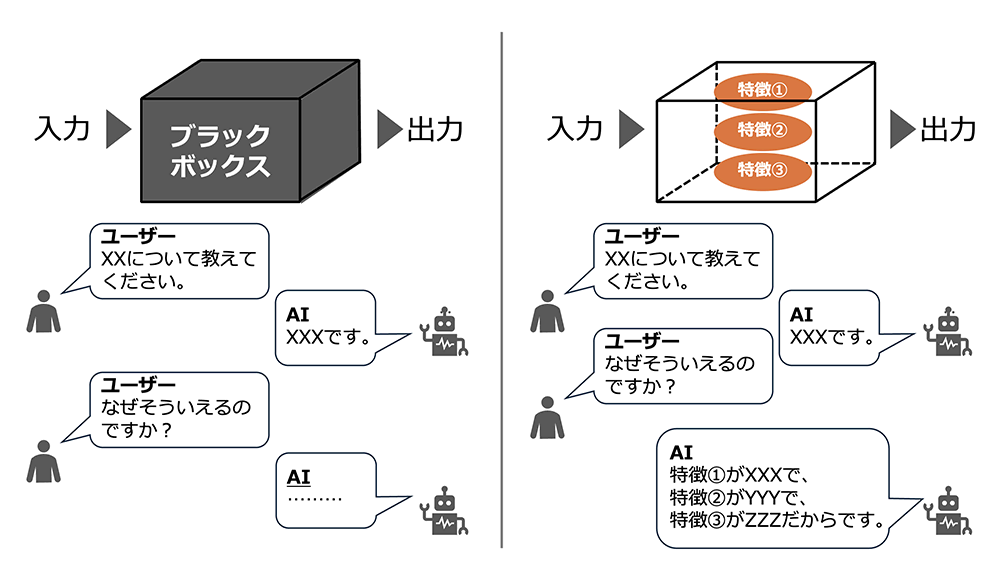

ChatGPTをはじめとするAIの進化は、私たちの生活を急速に大きく変えつつあります。しかし、その裏側で、AIが何を学習し、そこからどのような結論を導き出したのか、意思決定プロセスが外から見てもよくわからない「ブラックボックス化」という問題が顕在化しています。

この課題を解決するために注目されているのが「説明可能なAI(XAI: Explainable AI)」です。この記事では、XAIの基本概念から、具体的な手法やユースケースまでを解説します。

説明可能なAI(XAI)とは?

説明可能なAI(Explainable artificial intelligence:XAI)とは、AIの意思決定プロセスを人間が理解できる形で示す技術を指します。これは特定の技術やツールではなく、AIの判断根拠を明らかにする目的のために研究されている技術群の総称です。

この「説明可能なAI(XAI)」という概念は、2017年にアメリカ国防高等研究計画局(DARPA)が主導するプロジェクトが契機となりました。それ以前のAIは、内部の判断プロセスがブラックボックスとなっていて、結果のみを出力し、判断理由を説明できませんでした。しかし、XAIの登場により、AIの判断理由を可視化して透明性を高めることで、AIに対する信頼性がより向上するようになります。

参考:説明可能なAI – Wikipedia

https://ja.wikipedia.org/wiki/%E8%AA%AC%E6%98%8E%E5%8F%AF%E8%83%BD%E3%81%AAAI#cite_note-ooetc_p20-6

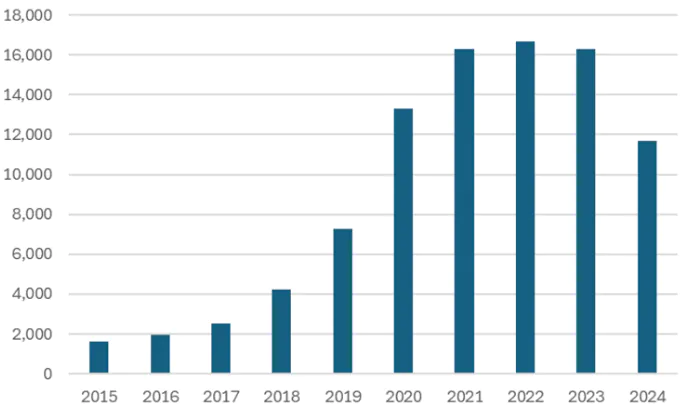

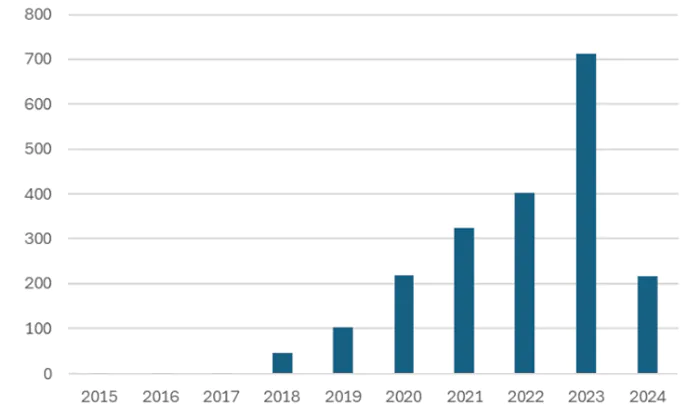

説明可能なAIは、近年注目を集める研究領域で、出版された論文数を見てもその注目度が窺えます。図2は、Google Scholarの関連論文(総説も含む)のヒット数です。ここ数年で、説明可能なAI関連の論文数が急増したことが分かります。同様に、プレプリントサーバーのarXivの結果(図3)を見ても、説明可能なAIに関する論文が上昇傾向にあり、注目度が年々高まっています。このように、説明可能なAIは、今後AIにおける重要な要素になることが予想されます。

説明可能なAIの代表的な手法—LIME

説明可能なAIを実現する代表的な手法のひとつが「LIME(Local Interpretable Model-Agnostic Explanations)」です。この手法は、AIモデルが出力した結果に対し、局所的な領域での解釈を可能にします。

LIMEの具体例―オオカミとハスキー犬の分類実験

この手法は、2016年に以下の論文で紹介され、LIMEを用いてAIの誤った分類結果を可視化する実験が行われました。

[1602.04938] Marco Tulio Ribeiro, Sameer Singh, Carlos Guestrin, “Why Should I Trust You?”: Explaining the Predictions of Any Classifier

https://arxiv.org/abs/1602.04938

実験内容

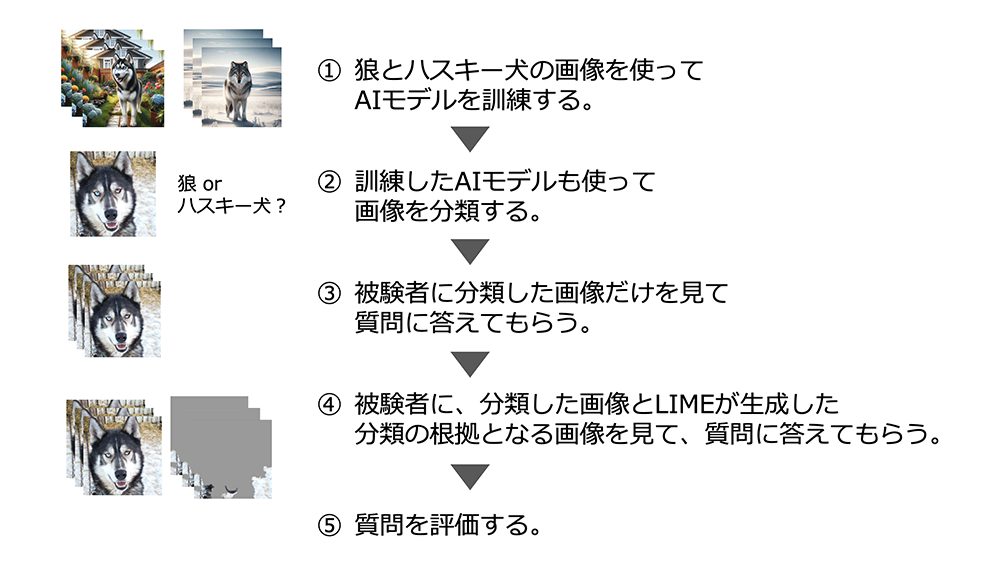

論文の筆者らは、オオカミとハスキー犬の分類の誤りについて、被験者が正しく洞察できるかを調査しました。この実験では、LIMEを用いてAIが注目した特徴を可視化し、被験者に提示しました。

- オオカミとハスキー犬を分類するAIモデルを用意

- オオカミの画像には雪の背景が多く含まれる一方で、ハスキー犬には雪の背景がない画像を選択

- AIモデルにこれらを学習させ、分類を実施

- AIは雪があるかどうかを基準に分類するようになり、誤った判断を下す

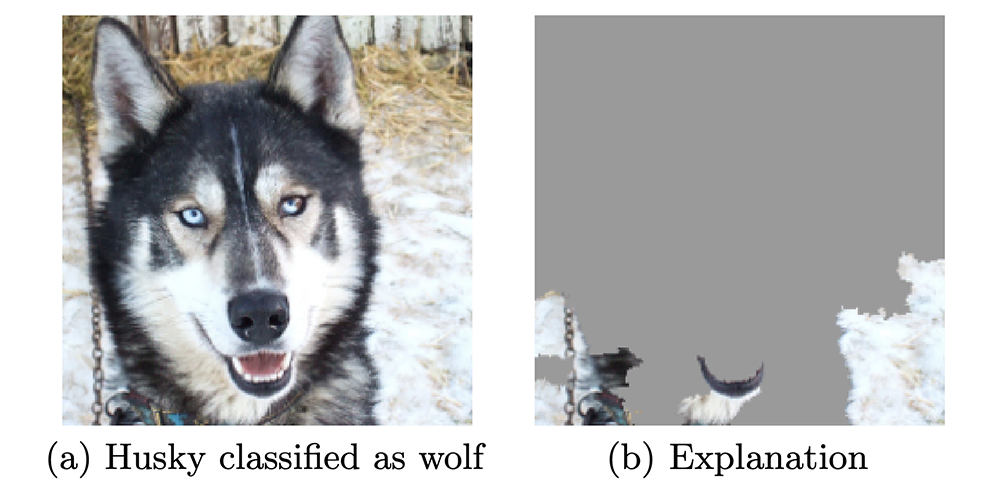

この実験ではオオカミの写真には背景に雪があり、ハスキー犬の写真には雪がない写真を選び、AIモデルに学習させました。その後、追加画像に対して、AIモデルは動物の色や位置、ポーズなどにかかわらず、雪がある場合は「狼」と分類し、そうでない場合は「ハスキー」と分類しました。この不適切なAIモデルを意図的に訓練し、被験者がそれを検出できるか評価しました。実験では、最初に分類結果(図4(a))を提示し、その後、被験者に次の3つの質問をしました。

- このアルゴリズムが実世界でうまく機能することを信頼するか?

- 信頼する理由は?

- このアルゴリズムが、狼とハスキー犬の写真をどのように区別していると思うか?

その後、説明付きの画像(図4(b))を示して同じ質問をしました。

この被験者は大学院生で、機械学習コースを受講した経験があります。評価者は、被験者の質問(3)で、「モデルが、雪や背景を分類の条件に使用していること示しているか?」どうかを判断しました。説明を見た後では、被験者のほぼ全員が正しい洞察を特定し、分類器に対する信頼度が大幅に低下しました。

この実験は、AIの知識がある学生を対象に実施されましたが、今後は研究や実証実験が進むことで、AIの知識がない人が見ても分かる根拠を示す、説明可能なAIが登場することが期待できます。

実験結果の要点

- 説明なしの状態では、被験者はAIを信頼する傾向が強かった

- LIMEによる説明を見た後、被験者のほとんどがAIの誤りを理解し、信頼度が低下した

出典:[1602.04938] Marco Tulio Ribeiro, Sameer Singh, Carlos Guestrin, “Why Should I Trust You?”: Explaining the Predictions of Any Classifier

https://arxiv.org/abs/1602.04938

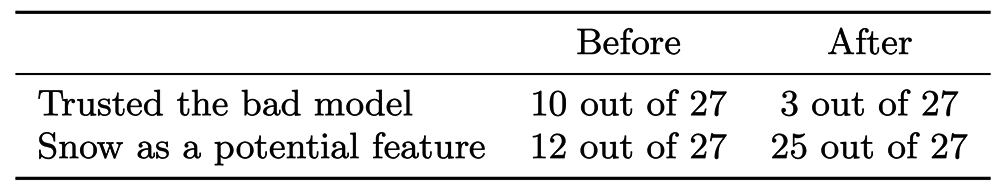

1行目-質問(1)の結果⇒根拠となる画像を見る前と後で、AIモデルの信頼度が大幅に低下している。

2行目-質問(3)の結果⇒根拠となる画像を見ることで、ほとんどの人が、AIモデルが雪や背景を分類の条件に使用していることを洞察できている。

出典:[1602.04938] Marco Tulio Ribeiro, Sameer Singh, Carlos Guestrin, “Why Should I Trust You?”: Explaining the Predictions of Any Classifier

https://arxiv.org/abs/1602.04938

想定される説明可能なAIのユースケース

次に、説明可能なAIが利用される事例について考えてみましょう。

医療・製薬分野

医療分野において、説明可能なAIは診断支援ツールとしての有用性には期待が高まっています。例えば、MRI画像をもとに癌を検出する際、AIがどのような特徴を根拠にその結論に至ったかを医師に提示することで、診断の正確性を向上させられます。AIが検出した異常に対する詳細な説明は、医師が患者へ説明する際にも有用な情報となり、患者の理解と信頼を深める助けとなります。

また、新薬の開発プロセスでは、AIが候補化合物を選定する際の根拠を示すことで、研究者が信頼を持って判断を下せるようになります。推論プロセスを解析することで、より有望な候補の早期発見につなげられます。

製造業

製造ラインにおける品質管理や生産プロセスの最適化にも、説明可能なAIの応用が期待されます。例えば、製造ライン上での製品の品質検査をAIが担当する場合、不良と判定した根拠を提供することで、生産プロセスのどの段階で問題が発生しているかを、正確に特定できます。これにより、生産効率の向上と品質の一貫性維持が可能になります。

以上のように、説明可能なAIの応用は、医療・製薬業界では診断精度の向上、新薬開発の加速が期待されます。また、製造業では、生産プロセスの最適化、品質管理の向上など、多岐にわたるメリットをもたらします。

AIの信頼性を向上させるカギ―XAIの未来

説明可能なAI(XAI)は、今後のAI技術の進展において重要な役割を果たします。透明性を確保することが、AIの誤判断によるリスクを軽減し、社会的受容を高めることにつながります。また、医療や製造業以外の分野にも導入が拡がることで、新たな価値を提供する可能性があります。

これからのAI社会において、説明可能なAIは不可欠な存在となるでしょう。その動向に注目です。