生成AIの「疾患」ハルシネーションが起きる理由とユーザーの対策

2024年も、ChatGPTなど生成AIの爆発的な発展に伴って、その可能性やリスクがさらに人々に広く知られるようになりました。多くの人たちが情報を知りたい時に最も使われるソフトウェアも、検索エンジンだけだったのが、一部は生成AIが使われつつあります。人々は便利さを享受する一方で、AIは万能ではなく、間違いを犯し続けることを忘れてしまっています。

前回の記事では、簡単な算数の問題でも生成AIが間違えてしまうことがある、ハルシネーション(幻覚)という概念について触れましたが、このハルシネーションとは一体何を指すのでしょうか。今回はこれについて説明します。

ハルシネーションとは?

まず、人間のハルシネーションに関するWikipediaの定義[1]を見てみましょう。

幻覚(げんかく、英語: hallucination)とは、外部からの刺激がないときに、現実の知覚と同じような性質を知覚することである。幻覚は鮮明で実質が伴っており、外部の客観的空間に位置するように知覚される。

これは人間の精神医学における症状の一つですが、人工知能においても、これは長年にわたってモデルの発展に影響を与えてきた重要な「疾患」です。Ziwei Ji[2]の論文では、人工知能のハルシネーションを以下のように定義しています。

The generated content that is nonsensical or unfaithful to the provided source content.

生成されたコンテンツが無意味であるか、提供されたソースコンテンツに忠実でない。

ハルシネーションは主に2つのタイプに分類されます。

第一のタイプは「内在的ハルシネーション」で、生成されたコンテンツがソースコンテンツと矛盾することを指します。簡単に言えば、質問に対して的外れな答えを返すことです。第二のタイプは「外在的ハルシネーション」と呼ばれ、生成されたコンテンツがソースコンテンツから検証できないものを指します。これは正しい場合も間違っている場合もあります。この説明はやや分かりにくいかもしれないので、例を挙げて説明しましょう。

中国では、あと2ヶ月で旧正月ですが、中国では正月に「福」の字を逆さまに貼る習慣があります。この理由についてChatGPTに質問したところ、次のような回答が得られました。

一方、以下はWikipediaでの「倒福(福の字を逆さまに貼ること)」[3]に関する説明です。

倒福(とうふく、拼音:dào fú)とは春節の際に家々に貼られる「福」の字を書いた赤色の紙。一般に上下逆さまに貼ることから「倒」(逆さにする)「福」と称される。「福」の文字は現在「幸福」の意味で使用されることが多いが、倒福では「福気・福運」の意味で使用されている。その福が到(中国語の発音は拼音: dào)るようにという願いを込めて、倒(拼音: dăo)して貼ることが一般的となっている。

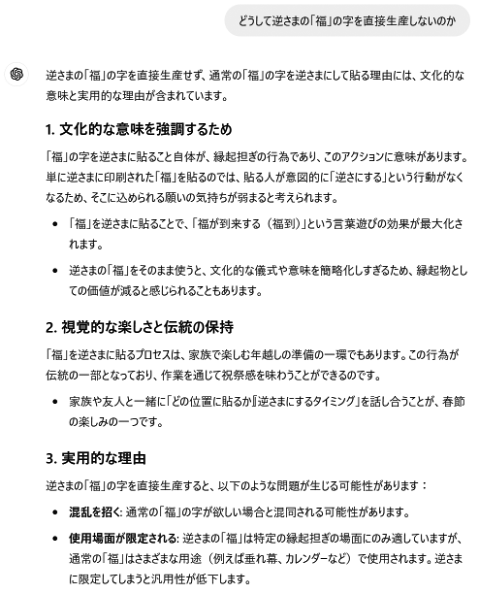

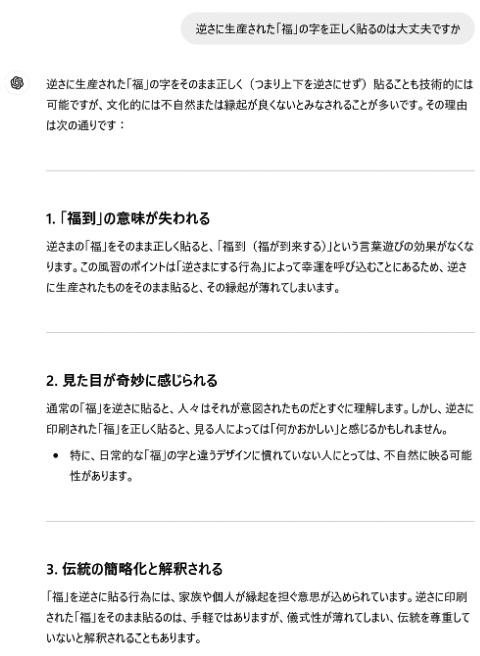

人間同士の会話であれば、「どうして逆さまの「福」の字を直接生産(印刷)しないのか?」と質問すれば、相手はこれが冗談だと理解するはずです。なぜなら、逆さまに作った「福」の字と正しい向きに作った「福」の字は全く同じもので、貼るときに天地を逆にするだけだからです。しかしChatGPTは、この明らかに誤った思考に対して、さまざまな理由を挙げて説明しました。

そこでさらに、この誤りに乗っかって質問を続けてみました。

これは、私たちがChatGPTを使用している時によく遭遇する、苦笑せざるを得ない場面の一つです。簡単に言えば、「ChatGPTは、真面目くさくなって的外れなことを言っている」ということです。

ハルシネーションが発生する原因

データベースや検索エンジンとは異なり、生成AIは質問に答える際、私たちのプロンプト(指示)に基づいてテキストを生成するだけです。この結果は、必ずしも訓練データで裏付けられているわけではありませんが、私たちのプロンプトと密接に関連しています。もしこれらのデータが不完全だったり古い、あるいは誤りを含んでいる場合、モデルは学習過程でこれらの誤った情報を吸収し、コンテンツを生成する際にそれを反映してしまいます。

また、生成AIは人間と同様に、知識の盲点があります。特定の分野やテーマにおいて、モデルは正確な答えを提供するための十分な知識を持っていないことがあります。この場合、既存の不完全な知識に基づいて回答することがあり、その結果、不正確な内容が生じることがあります。

さらに、モデルをより賢く、人間らしくするために、開発者はさまざまなトレーニング目標を設定しました。しかし時には、これらの目標がモデルに生成する内容の流暢さや合理性を追求させすぎて、内容の正確性を無視することがあります。つまりモデルは、実際には正確ではないにも関わらず、いかにもそれらしい答えを出す傾向があるのです。

生成AIを使用する際に意識すべき思考

ChatGPTなどの生成AIを使用する際、この問題にどのように対処すべきでしょうか?

まず、批判的思考(クリティカルシンキング)を持つことが重要です。AIが提供する答えをそのまま受け入れるのではなく、全てを信じる必要も全く信じない必要もありません。自分自身の考えと理解を持つ必要があります。答えが論理的でない、または信頼できないように見える場合は、さらに確認することが望ましいです。

次に、信頼できる情報源を使用することです。重要な決定や問題についてより深く理解したい場合は、専門書籍や学術論文、信頼できるニュースなどを参照し、多角的な視点から問題を総括することが望ましいです。

そして、もし興味があれば、生成AIの仕組みについて理解を深めることもおすすめです。ChatGPTが大量のテキストデータを分析して「学習」するという概念を知った上で、生成AIの限界をより良く理解できます。

ハルシネーションを克服する研究は続く

ハルシネーションを完全に排除することは不可能です。しかし、以下のような方法でハルシネーションを可能な限り減少させる、あるいはその影響を軽減するために、研究が続けられています。

- 自動ハルシネーション検出・評価方法:注意力機構に基づく分析や統計的手法など、より効果的な自動化ツールの開発

- クロスドメイン・マルチモーダル手法:画像、動画、テキストなど、異なる領域間でのハルシネーション識別と処理の探求

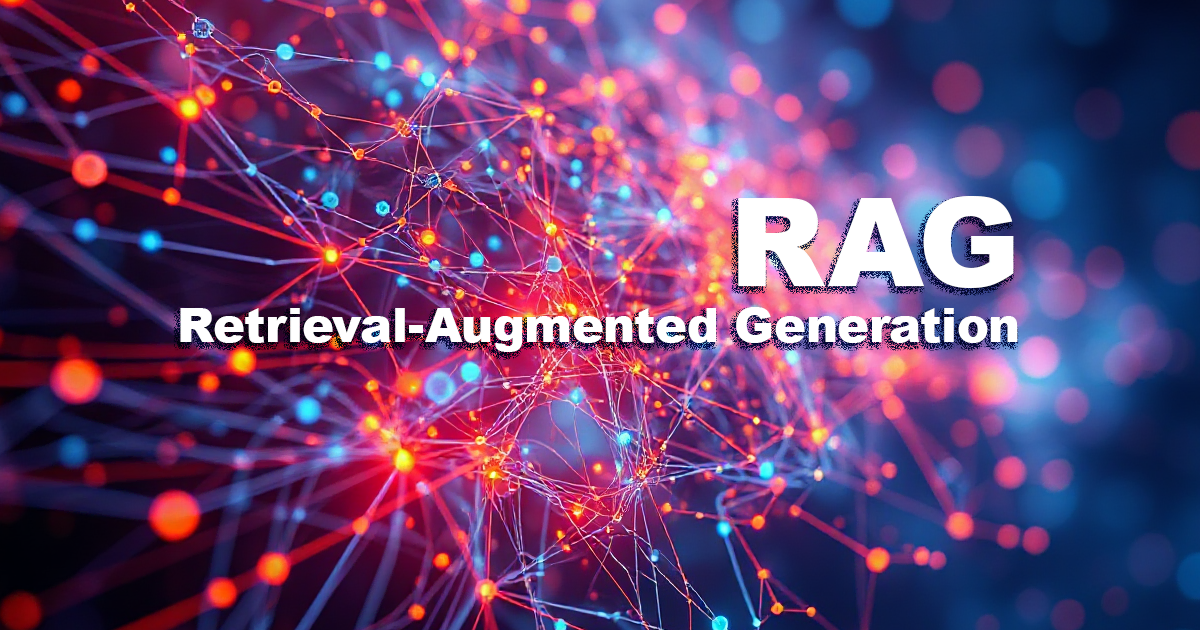

- 現実世界の知識の強化:外部情報や文脈知識をより多く統合し、現実世界に対するモデルの理解力を向上

- モデルの可解釈性と透明性:モデルの可解釈性を高め、ハルシネーションの原因をより良く理解・説明できるようにする

参考文献

[1]

[2] Ji, Ziwei, et al. [2202.03629] Survey of Hallucination in Natural Language Generation ACM Computing Surveys 55.12 (2023): 1-38.

https://arxiv.org/abs/2202.03629

[3]