AIにとっての「言葉」である自然言語処理の発展の歴史を振り返ろう

皆さんは、生成AIを使っていますか?多くの人が、ChatGPTなどを一度は試してみたことがあるでしょう。前回の記事では、AIの「目」であるコンピュータービジョンについて紹介しました。今回と次回の記事では、AIの「言葉」である自然言語処理の発展と歴史、仕組みを紹介します。

自然言語と処理

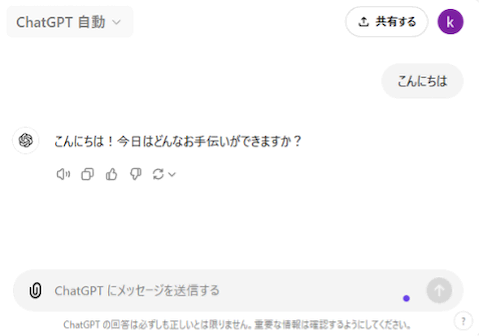

このスクリーンショットはChatGPTのインターフェイスですが、他社のAIも同じようなUIです。このようなチャット形式のやり取りを通じて、人々はAIに質問したり、回答に対してさらに指示を出すことで、仕事や生活がますます便利になっています。コンピューターサイエンスでは、人間とコンピューターの対話のこのタスクを自然言語処理(Natural Language Processing、NLP)と呼んでいます。

自然言語処理は、AIとコンピューターサイエンスにおける重要な分野の一つであり、コンピューターが人間の言語を理解や解析、生成できるようにすることを目指しています。

自然言語とは、日本語や英語、中国語など、人々が日常的に使用する言語のことを指し、人類社会の発展と進化によって生まれたものです。これは人間がコミュニケーションを取ったり、学習したり、生活する上で重要なツールです。一方、人工言語は、研究者が特定の目的のために作り出した言語システムです。

自然言語処理は、コンピューターを使って自然言語に含まれるさまざまな情報を処理することを指します。つまり、文章や段落の分析、理解、生成などを操作し、人間とコンピューター間の情報交換を実現します。日常生活でよく見られる応用例には、翻訳や音声認識などがあります。

自然言語処理には、目指している2つの主要な方向性があります:

・自然言語理解:コンピューターが自然言語テキストの意味を理解できるようにすること

・自然言語生成:コンピューターが与えられた意図を自然言語テキストで表現できるようにすること

現在の理論と技術から見ると、汎用的で高品質な自然言語処理システムの実現は依然として長期的な目標です。しかし、特定の応用を目的とした、かなり高度な自然言語処理能力を持つ実用的なシステムはすでに登場しています。典型的な例としては、各種の翻訳システムや全文情報検索システム、自動要約システムなどが挙げられます。一部では、商品化・産業化も始まっています。

自然言語理解レベル

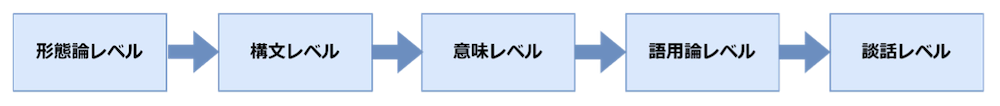

自然言語の理解と分析は階層的なプロセスです。多くの言語学者はこのプロセスを5つのレベルに分類しています[1]。この各レベルを理解することで、言語自体の構成をより良く表現できます:

- 形態論レベル(Morphological Level)

・最も基本的なレベルで、単語の構造と形式に関わります。

・主なタスクには、語形復元や語幹抽出、接辞分析などが含まれます。

例:「running」を「run」の現在進行形として認識すること。 - 構文レベル(Syntactic Level)

・このレベルは文の文法構造に焦点を当てます。

・主なタスクには、品詞タグ付け、構文解析、依存関係分析などが含まれます。

例:「The cat chased the mouse(猫はネズミを追いかけた)」の中で主語、述語、目的語を識別すること。 - 意味レベル(Semantic Level)

・このレベルは単語と文の意味に焦点を当てます。

・主なタスクには、語義曖昧性解消、意味役割ラベリング、固有表現認識などが含まれます。

例:「bank」が「river bank(川岸)」と「bank account(銀行口座)」で異なる意味を持つことを理解すること。 - 語用論レベル(Pragmatic Level)

・このレベルは特定の文脈における言語の使用を考慮します。

・主なタスクには、照応解決、含意理解、談話分析などが含まれます。

例:「ここは寒いですね」が、窓を閉めることの間接的な要求である可能性を理解すること。 - 談話レベル(Discourse Level)

・これは最高レベルで、複数の文や段落間の関係を扱います。

・主なタスクには、トピック検出、テキスト要約、テキスト一貫性分析などが含まれます。

例:記事全体の構造と主要な論点を理解すること。

自然言語を理解するこれら5つのレベルは段階的で、それぞれが前のレベルの基礎の上に築かれています。

自然言語処理の発展の歴史

自然言語理解の分野における最初の研究は機械翻訳でした。1949年、アメリカ人科学者・数学者のウォーレン・ウィーバーが初めて機械翻訳の設計案を提案しました。翌1950年、アラン・チューリングが有名な「チューリングテスト」を提案し、これは一般的に自然言語処理の思想の始まりとされています。

1950年代から70年代にかけて、研究者たちは特定の条件に基づいて問題を解決する、ルールベースのアプローチを採用しました。しかし当時は、明らかに自然言語の複雑さが過小評価されていて、言語処理の理論と技術はまだ成熟しておらず、大きな進展はありませんでした。70年代以降、インターネットの急速な発展に伴い、豊富なコーパス(大量のテキストデータを集積し、品詞などの情報を加えて構造化したデータベース)が利用可能になりました。同時に、ハードウェアも継続的に更新・改善されたことで、自然言語処理の潮流は経験主義から合理主義へと移行し、ルールベースの方法に代わり統計ベースの方法が徐々に拡がりました。

2008年から現在まで、画像認識と音声認識の分野での成果に触発され、研究者たちは徐々にディープラーニング(深層学習)を自然言語処理研究に導入し始めました。ディープラーニングは多層のニューラルネットワークで、入力層から始まり、層ごとの非線形変換を経て出力を得ます。入力から出力まで、エンドツーエンド(End-to-End)で訓練します。入力と出力のペアのデータを準備し、ニューラルネットワークを設計・訓練することで、想定されたタスクを実行できます。

そして2017年、Googleは論文「Attention Is All You Need」[2]で、初めてTransformerモデルを提案しました。これは、以前のモデルのさまざまな制限(推論速度の遅さ、文脈情報の捕捉能力の弱さ、モデルの巨大さなど)を解決し、AI分野全体の進歩を促進する新しい研究でした。モデル設計の当初の目的は機械翻訳でしたが、現在ではTransformerの影響は当初の設計目標を遙かに超え、現代のディープラーニングにおいて最も重要なアーキテクチャーの一つとなっています。

ChatGPTの誕生と、さまざまなAIの発展

Transformerモデルの登場以降、自然言語処理の分野は急速に発展しました。特に、大規模言語モデル(Large Language Models、LLMs)の出現により、AIの能力は飛躍的に向上しました。

2018年、OpenAIがGPT(Generative Pre-trained Transformer)[3]を発表しました。これは、Transformerアーキテクチャーを基にした最初の大規模言語モデルの一つでした。GPTは、膨大な量のテキストデータで事前学習し、さまざまなタスクに適応できる汎用性の高いモデルとして注目を集めました。

2020年、OpenAIはさらに大規模なGPT-3を発表しました。1,750億個のパラメーターを持つGPT-3は、少ないデータで効率的に学習できるfew-shot learningの能力を示しました。また、AIに適切な指示を与えてその能力を最大限に引き出す技術として、プロンプトエンジニアリングという新しい概念を生み出しました。

その後、2022年にOpenAIはChatGPTを一般公開し、AIが一般のニュースでも取り上げられるほど大きな反響を呼びました。ChatGPTは、GPT-3.5をベースに対話タスク向けに最適化されたモデルで、自然な会話能力と幅広い知識を持つことで注目を集めました。

さらに2023年には、OpenAIがGPT-4を発表し、複数のデータ形式の情報を関連付けて統合的に処理するマルチモーダル機能や、さらに高度な推論能力を示しました。同年、AnthropicのClaude、GoogleのBard、MetaのLLaMAなど、多くの企業や組織が独自のLLMを公開し、AIの民主化が進みました。今年2024年も、OpenAIが次世代モデルGPT-4oやGPT-4o miniを発表するなど、競合他社製品も含め、生成AIの発展と普及は留まるところを知りません。

AIの自然言語処理と課題は新たな段階へ

これらのLLMの発展により、自然言語処理は新たな段階に入りました。しかし、同時にAIの倫理的使用やバイアス、ハルシネーション(誤った情報の生成)などの課題も浮き彫りになっています。今後は、これらの課題に取り組みながら、より信頼性が高く、人間にとって有益なAIシステムの開発が期待されています。

参考文献

[1] [PDF] Allen, James. Natural Language Understanding Benjamin-Cummings Publishing Co., Inc., 1988. | Semantic Scholar https://www.semanticscholar.org/paper/Natural-Language-Understanding-Allen/ba6797b59c38702725ea0f3e6c141d471164662e

[2] [1706.03762v5] Vaswani, A. “Attention is all you need.” Advances in Neural Information Processing Systems (2017). https://export.arxiv.org/abs/1706.03762v5

[3] Liu, Yiheng, et al. “Summary of ChatGPT-Related research and perspective towards the future of large language models” Meta-Radiology (2023): 100017 – ScienceDirect https://www.sciencedirect.com/science/article/pii/S2950162823000176