アテンションで注目!AIの「言葉」である自然言語処理の仕組み

自然言語処理(NLP:Natural Language Processing)を含む深層学習は、本質的に強力な特徴学習とパターン認識の方法です。大量のデータから有用な特徴表現を自動的に抽出し、さまざまな複雑な知的タスクを完了させます。効率的な特徴抽出については、研究者たちが絶えず努力しながら研究を続けています。

今日の主役は、アテンション(注意力)です。アテンションとはこの用語どおり、AIモデルが人間のように、重要な情報に対して選択的に注意を向けることです。この機能により、人工知能モデルの質は飛躍的に向上を遂げました。現在よく知られているLLMモデル(ChatGPT、GoogleのBard、MetaのLLaMaなど)はすべて、このアテンションの恩恵を受けています。前回の記事では、自然言語処理の発展の歴史について紹介しました。今回は、自然言語処理の仕組みについて説明します。

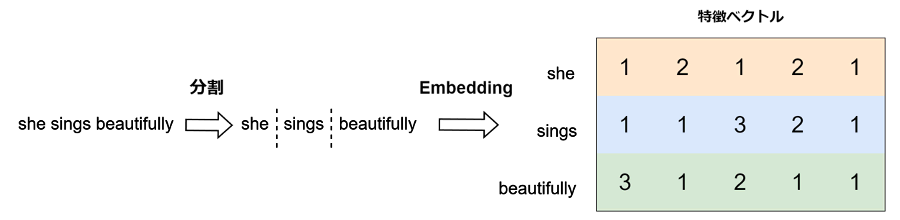

1. エンベッディング(埋め込み)

まず、入力文を分割し、各単語を単語ベクトル列に変換します。簡単に言えば、自然言語を機械が理解できる数値の組に変換することです。このプロセスには通常、Word2Vec、BERTなどの、事前学習済み単語埋め込みモデルが使用されます。

以下の英文を例に説明します。

“She sings beautifully.”

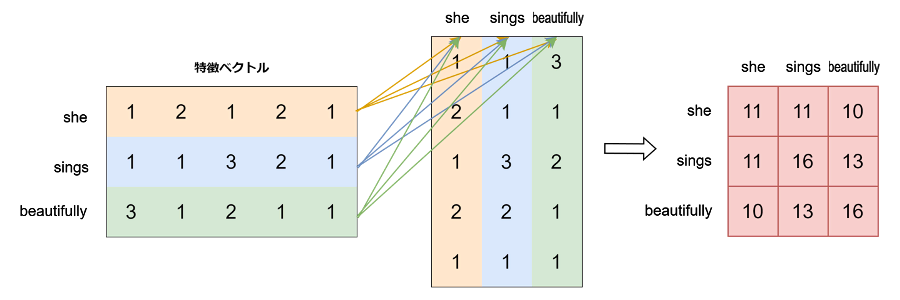

2. アテンションスコアの計算

次に、各単語と他のすべての単語との関連性を計算します。ベクトルの内積が関連性を測る指標となります。

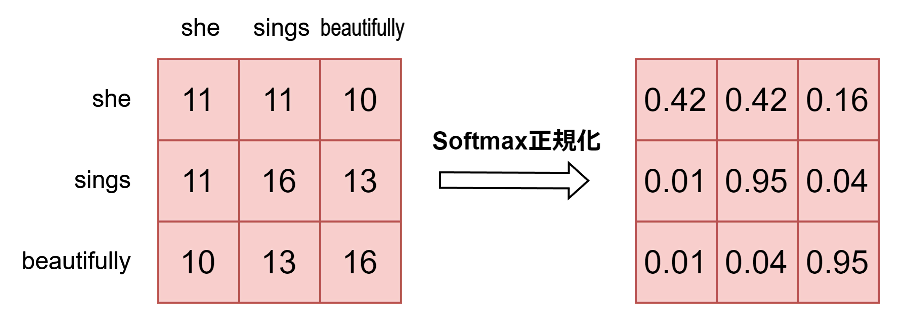

3. アテンション重みの計算

続いて、スコアにソフトマックス関数を適用し、アテンション重みを得ます。ソフトマックス関数は元のスコアを確率分布に変換し、すべての重みの合計が1になるように計算します。

4. 重み付け和

次に、アテンション重みを使用してベクトルの重み付け和を計算し、コンテキストベクトルを得ます。このステップですべての関連情報が融合されます。

この例で一番右の結果に注目すると、次のことがわかります。

- 1行目:比較的均等なアテンション分布で、3と4番目の要素(1.84)にやや偏っている。

- 2行目:3番目の要素(2.94)の注目が高く、次いで4番目の要素(2.06)に注目している。

- 3行目:1番目の要素(2.86)の注目が特に高く、他の要素への注目度は比較的低くなっている。

簡単に言えば、こういう傾向がわかります。

- 1番目の単語”She”は、すべての単語とある程度関連しているが、3番目の単語との関係がやや強い。

- 2番目の単語”sings”は、3番目の単語と強い関連がある。

- 3番目の単語”beautifully”は、1番目の単語と強い関連がある。

5. モデルの最適化

最後に、人為的にさまざまなパラメーターを調整し、機械が意味を正確に理解できるようにします。

もう一度 “She sings beautifully.” を見てみましょう。

“She”は文の主語として、他の2つの単語とある程度の関連性があります。”She”はまた、全体の動作の主体で、”beautifully”と間接的な描写関係があります。”sings”と”beautifully”の間には直接的な修飾関係があります。これは上記の計算結果と一致しています。

- “She”:他の2つの単語とある程度関連していますが、特に突出した関係はありません。これは1行目の比較的均等なアテンション分布に一致します。

- “sings”:3番目の単語”beautifully”と強い関連があります。これは、2行目の3番目の要素への高い注目度に一致します。動詞”sings”は直接副詞”beautifully”と結びつき、歌い方を描写しています。

- “beautifully”:1番目の単語”She”と強い関連があります。これは、3行目の1番目の要素への高い注目度に一致します。副詞”beautifully”は動詞”sings”を修飾するだけでなく、間接的に”She”の能力も描写しています。

アテンションのさまざまな改善法

今回は、アテンション機構の仕組みを簡単に説明した例に過ぎません。実際にコンピューターに与える計算タスクはより複雑です。例えば、以下のような改善法が考えられています。

- 各単語の特徴を豊かにするため、エンベディング時に1つの単語を数百次元の単語ベクトルに変換します。通常、これらのベクトルの次元は100から1000の間で、例えばBERT-baseは768次元のベクトルを使用します。

- 各ステップの計算には複数の重み行列が含まれていて、深層学習の深さと広さを増やすと同時に、トレーニング時のモデル調整に役立ちます。

- モデルを現在のタスクにより適用させるために、複数の計算方法を使用します。例えば、基本的な内積アテンションの他に、加法アテンション、乗法アテンションなどの変種があります。さらに、位置エンコーディングやレイヤー正規化などの技術も、モデルのパフォーマンスを向上させるために使用されます。

アテンションによる自然言語処理の急速な発展

アテンション機構の革新的なアイデアは、2014年頃まで遡ることができます。注目すべきは、自然言語処理分野を本当に革新したのは、2017年に発表された”Attention is All You Need”論文で、Transformerアーキテクチャが導入されたことです。このアーキテクチャは完全にアテンション機構に基づいていて、従来の再帰型ニューラルネットワーク構造を排除しました。

▼[1706.03762] Attention Is All You Need

https://arxiv.org/abs/1706.03762

2017年から現在まで、わずか数年の間に、BERT、GPTシリーズ、T5などのTransformerベースのモデルが次々と登場し、自然言語処理技術の急速な発展を推進しました。ChatGPTなどの大規模言語モデルの成功は、まさにこれらの基礎研究の上に築かれたものです。

AIの発展は確かに爆発的な成長を示していますが、その背後には数十年にわたる基礎研究の蓄積と計算能力の指数関数的な向上があります。将来、AI技術がより多くの分野で重要な役割を果たすことが期待されています。例えば、医療診断や科学研究、教育の個別化などです。同時に、AIの発展がもたらす倫理的・社会的問題にも注意を払い、技術の発展と人類の福祉が調和するよう確保する必要があります。